日期:2023/06/30 10:07作者:佚名人气:

经常有朋友需要帮忙做公众号文章爬取,这次来做一个各种方法的汇总说明。目前爬取微信公众号的方法主要有3种:1. 通过爬取第三方的公众号文章聚合网站1. 通过微信公众平台引用文章接口1. 通过抓包程序,分析微信app访问公众号文章的接口## 通过第三方的公众号文章聚合网站爬取微信公众号文章一直没有提供一个对外的搜索功能,直到2013年微信投资搜狗之后,搜狗搜索接入微信公众号数据,从此使用搜狗搜索就可以浏览或查询到相关公众号以及文章。域名是: 可以直接搜索公众号或者文章的关键字,一些热门的公众号更新还是很及时的,几乎做到了和微信同步。所以,爬一些热门公众号可以使用搜狗微信的接口来做,但是一些小众公众号是搜索不到的,而且搜狗的防爬机制更新的比较勤,获取数据的接口变化的比较快,经常两三个月就有调整,导致爬虫很容易挂,这里还是建议使用 `selenium` 爬比较省心。另外搜狗对每个ip也有访问限制,访问太频ip会被封禁24小时,需要买个ip池来做应对。

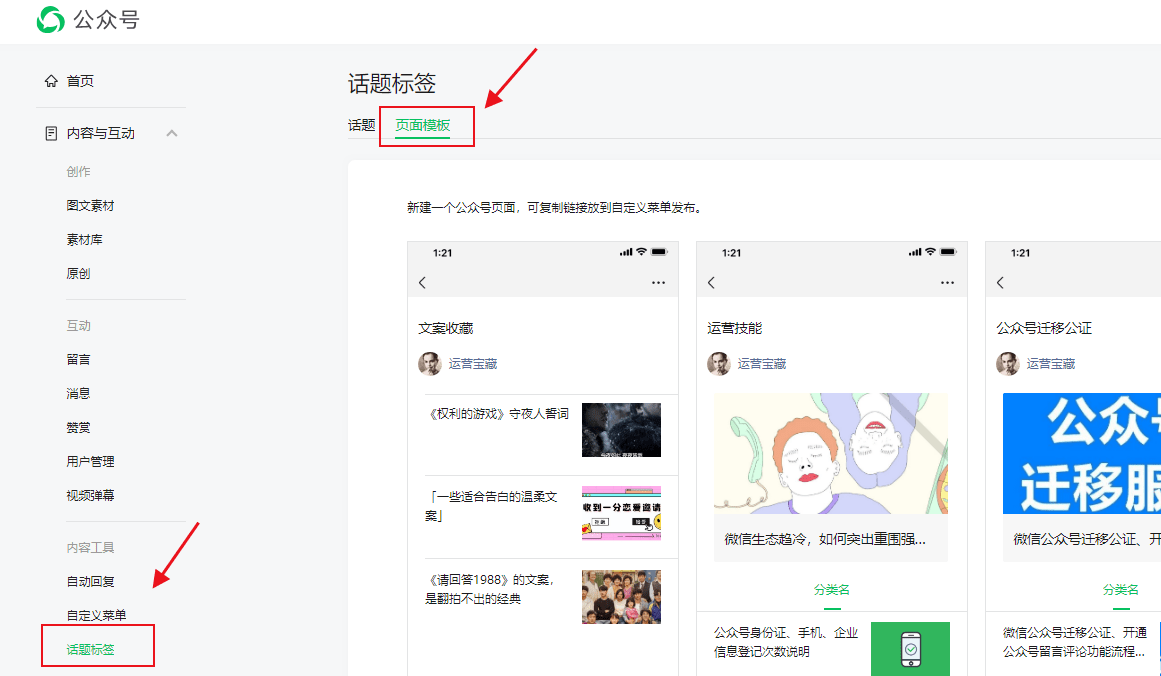

还有一些其他公众号文章聚合网站(比如传送门)也都存在更新不及时或者没有收录的问题,毕竟搜狗这个亲儿子都不行。## 通过微信公众平台引用文章接口这个接口比较隐蔽而且没法匿名访问,所有得有一个公众号,建议新注册一个公众号比较好,免得被封。下面开始具体步骤:首先登录自己的微信公众号,在进去的首页选择`新建群发`,然后再点击`自建图文`,在文章编辑工具栏中找到`超链接`,如下图:点击这个超链接按钮,就会弹出一个对话框,链接输入方式这一项选中`查找文章`,如下图:到这里就可以输入公众号的名字,回车之后微信就会返回相匹配的公众号列表,如下图:接着点击你想抓取的公众号,就会显示具体的文章列表了,已经是按时间倒序了,最新的文章就是第一条了。如下图:微信的分页机制比较奇怪,每个公众号的每页显示的数据条数是不一样的,分页爬的时候要处理一下。通过chrome分析网络请求的数据,我们想要的数据已经基本拿到了微信公众号 网站,文章链接、封面、发布日期、副标题等微信公众号 网站,如下图:OK,这种方法爬取的原理讲完了,下面开始实操了。

由于微信公众平台登录验证比较严格,输入密码之后还必须要手机扫码确认才能登录进去,所以最好还是使用`selenium`做自动化比较好。具体微信接口的分析过程我就不列了,直接贴代码了:```import reimport timeimport randomimport tracebackimport requestsfrom selenium import webdriverclass Spider(object):'''微信公众号文章爬虫'''def __init__(self):# 微信公众号账号self.account = ''# 微信公众号密码self.pwd = ''def create_driver(self):'''初始化 webdriver'''options = webdriver.ChromeOptions()# 禁用gpu加速,防止出一些未知bugoptions.add_argument('--disable-gpu')# 这里我用 chromedriver 作为 webdriver# 可以去 下载你的chrome对应版本self.driver = webdriver.Chrome(executable_path='./chromedriver', chrome_options=options)# 设置一个隐性等待 5sself.driver.implicitly_wait(5)def log(self, msg):'''格式化打印'''print('------ %s ------' % msg)def login(self):'''登录拿 cookies'''try:self.create_driver()# 访问微信公众平台self.driver.get('https://mp.weixin.qq.com/')# 等待网页加载完毕time.sleep(3)# 输入账号self.driver.find_element_by_xpath("./*//input[@name='account']").clear()self.driver.find_element_by_xpath("./*//input[@name='account']").send_keys(self.account)# 输入密码self.driver.find_element_by_xpath("./*//input[@name='password']").clear()self.driver.find_element_by_xpath("./*//input[@name='password']").send_keys(self.pwd)# 点击登录self.driver.find_elements_by_class_name('btn_login')[0].click()self.log("请拿手机扫码二维码登录公众号")# 等待手机扫描time.sleep(10)self.log("登录成功")# 获取cookies 然后保存到变量上,后面要用self.cookies = dict([[x['name'], x['value']] for x in self.driver.get_cookies()])except Exception as e:traceback.print_exc()finally:# 退出 chormeself.driver.quit()def get_article(self, query=''):try:url = 'https://mp.weixin.qq.com'# 设置headersheaders = {"HOST": "mp.weixin.qq.com","User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/72.0.3626.109 Safari/537.36"}# 登录之后的微信公众号首页url变化为:,# 从这里获取token信息response = requests.get(url=url, cookies=self.cookies)token = re.findall(r'token=(\d+)', str(response.url))[0]time.sleep(2)self.log('正在查询[ %s ]相关公众号' % query)search_url = 'https://mp.weixin.qq.com/cgi-bin/searchbiz?'# 搜索微信公众号接口需要传入的参数,# 有三个变量:微信公众号token、随机数random、搜索的微信公众号名字params = {'action': 'search_biz','token': token,'random': random.random(),'query': query,'lang': 'zh_CN','f': 'json','ajax': '1','begin': '0','count': '5'}# 打开搜索微信公众号接口地址,需要传入相关参数信息如:cookies、params、headersresponse = requests.get(search_url, cookies=self.cookies, headers=headers, params=params)time.sleep(2)# 取搜索结果中的第一个公众号lists = response.json().get('list')[0]# 获取这个公众号的fakeid,后面爬取公众号文章需要此字段fakeid = lists.get('fakeid')nickname = lists.get('nickname')# 微信公众号文章接口地址search_url = 'https://mp.weixin.qq.com/cgi-bin/appmsg?'# 搜索文章需要传入几个参数:登录的公众号token、要爬取文章的公众号fakeid、随机数randomparams = {'action': 'list_ex','token': token,'random': random.random(),'fakeid': fakeid,'lang': 'zh_CN','f': 'json','ajax': '1','begin': '0', # 不同页,此参数变化,变化规则为每页加5'count': '5','query': '','type': '9'}self.log('正在查询公众号[ %s ]相关文章' % nickname)# 打开搜索的微信公众号文章列表页response = requests.get(search_url, cookies=self.cookies, headers=headers, params=params)time.sleep(2)for per in response.json().get('app_msg_list', []):print('title ---> %s' % per.get('title'))print('link ---> %s' % per.get('link'))# print('cover ---> %s' % per.get('cover'))except Exception as e:traceback.print_exc()if __name__ == '__main__':spider = Spider()spider.login()spider.get_article('python')```代码只是作为学习使用,没有做分页查询之类。据网友称,这个接口也有访问频次限制,一天几百次还是没啥问题,太快或者太多次访问就会被封24小时。下一篇我们来讲讲如何获取文章的阅读数和点赞数。## 参考文章https://cuiqingcai.com/4652.html